英伟达创始人兼 CEO 黄仁勋周二在公司年度 AI 开发者大会上向数千名观众表示,人工智能正处于“关键拐点”。

在这个被誉为“AI 界超级碗”的 GTC 2025 上,黄仁勋的主题演讲聚焦于英伟达在 AI 领域的最新突破,并分享了他对未来几年行业发展的预测。

他指出,全球四大云服务提供商对 GPU 的需求激增,并预计英伟达的数据中心基础设施收入将在 2028 年突破 1 万亿美元。黄仁勋表示,要推动人工智能的发展,特别是朝着 AI 代理(AI Agent)和推理 AI 模型(Reasoning AI Model)的方向迈进,需要强大的计算能力,甚至远超当前水平。

这一趋势向 AI 代理和推理 AI 迈进,意味着“训练和推理这些模型所需的计算量大幅增长”。

相比之下,传统的大语言模型(LLM)计算需求较低,并能立即生成回答。而推理模型则需要在回答之前进行多轮内部推理,因此计算需求大得多,响应时间也更长。“为了保持模型的响应速度,让用户不会因等待而失去耐心,我们现在需要将计算速度提高 10 倍,”黄仁勋表示,“而整体计算需求则轻松增长至 100 倍。”

黄仁勋此番言论,意在强调 AI 行业仍然需要大量的英伟达 GPU。

然而,今年 1 月,AI 初创公司 DeepSeek 透露,他们仅使用 2000 颗较慢的英伟达 H800 芯片,就训练出高性能的基础 AI 模型,而 OpenAI 等公司通常需要成千上万甚至更多的 GPU。

此消息一度引发市场担忧,导致英伟达股价暴跌,一天内市值蒸发近 6000 亿美元,华尔街投资者担心 GPU 需求被高估。

但黄仁勋认为,未来 AI 代理和推理 AI 的发展将带来更大需求。他预测,未来全球 10 亿知识工作者身边将有 100 亿 AI 代理协同工作。

市场需求的强劲增长已有迹可循。

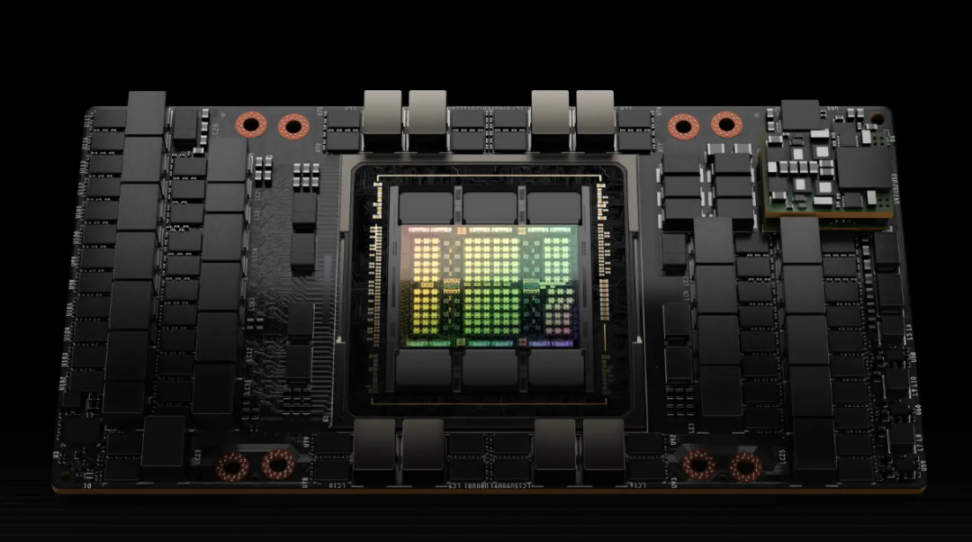

黄仁勋透露,在英伟达 Hopper 架构 GPU 需求巅峰的那一年,公司向 AWS、微软、谷歌和甲骨文这四大云计算公司交付了 130 万颗芯片。而最新的 Blackwell 架构 GPU 在推出第一年,就已经出货 360 万颗。

此外,演讲中,黄仁勋展示了一场 AI 模型对决——Meta 的 Llama 开源模型与 DeepSeek 的 R1 推理模型。用户向两款模型提出了一个婚礼座位安排问题:在 7 个座位的桌子上,确保新娘和新郎的父母不相邻,并满足其他约束条件。

Llama 迅速给出答案,生成了 439 个 token(每个 token 约等于 0.75 个单词),但答案是错误的。而 R1 虽然正确解答,但计算时间更长,生成了 8,559 个 token。由于用户需按 token 付费,计算成本也更高。

黄仁勋表示,虽然有优化技术可以提高 AI 计算效率,从而减少计算资源消耗,但整体需求仍将持续增长。

AI 计算效率也是诸多初创公司正在攻克的难题。例如,斯坦福大学、加州大学洛杉矶分校和康奈尔大学教授联合创立的 Inception Labs,正研发并行计算技术,使 AI 生成 token 的过程由传统的逐个生成,改为并行生成,从而降低 GPU 计算时间。

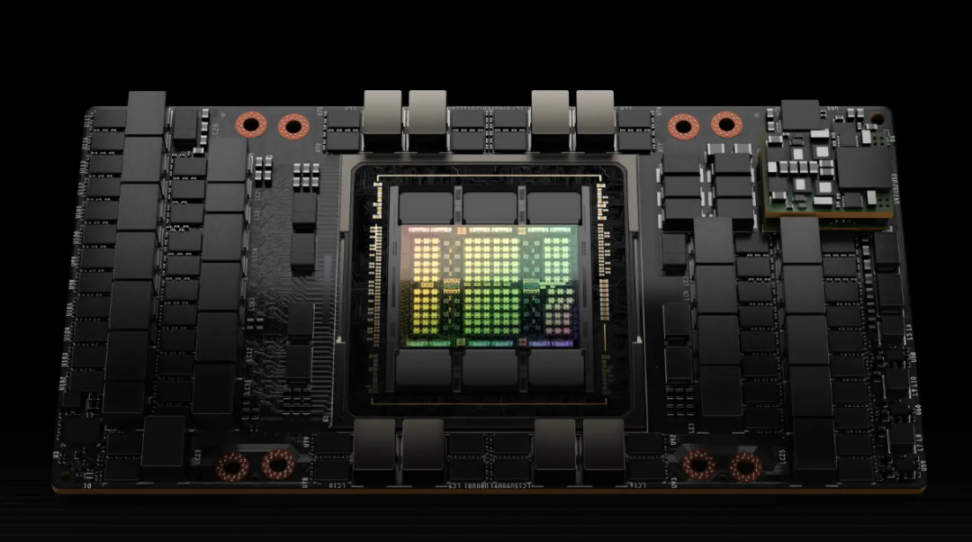

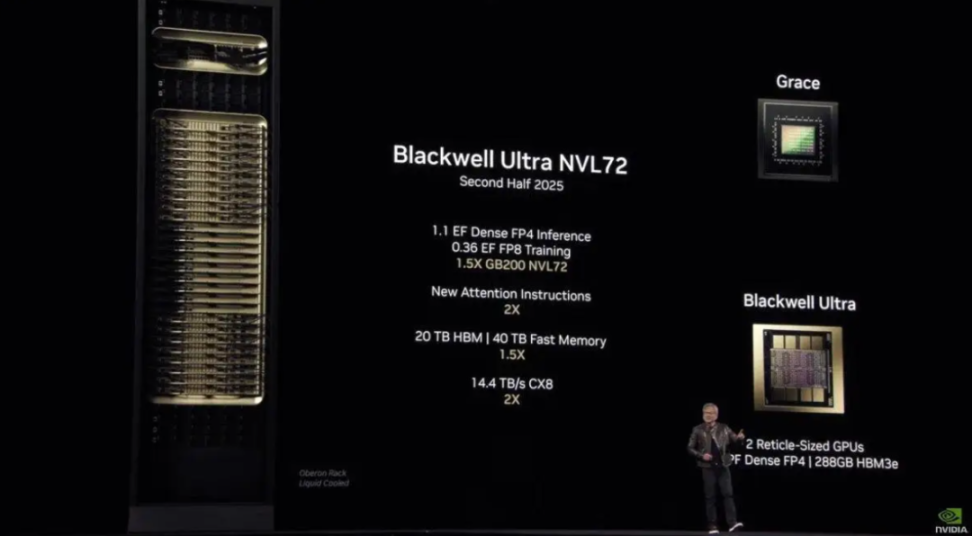

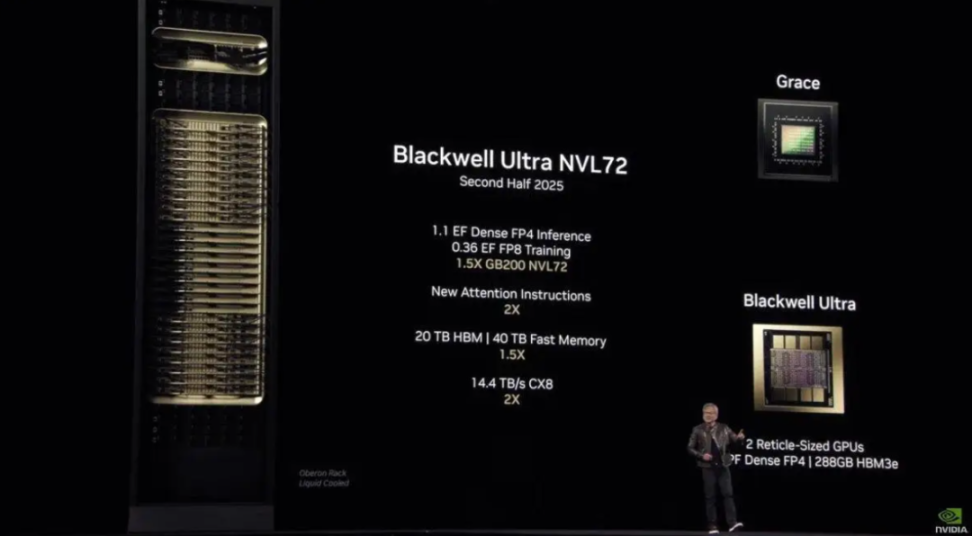

重磅:Blackwell Ultra 与 Rubin AI 芯片在万众期待的发布环节,黄仁勋透露了英伟达下一代 GPU 架构的更多细节:- Blackwell Ultra:计划于 2025 年下半年推出;

- Vera Rubin(RubinAI 芯片,以著名天文学家 Vera Rubin 命名):预计 2026 年底发布;

在长达两个多小时的演讲中,黄仁勋回顾了 AI 领域的“非凡进步”。

他表示,在过去十年间,AI 已从最初的感知和计算机视觉发展到生成式 AI,而如今正迈向具备推理能力的智能 AI(Agentic AI)。这意味着 AI 不仅能理解和生成内容,还具备自主推理和智能决策的能力。

此次 GTC 2025 的发布,标志着英伟达在 AI 计算领域迈向新阶段,也预示着 AI 未来发展将进入更高维度。

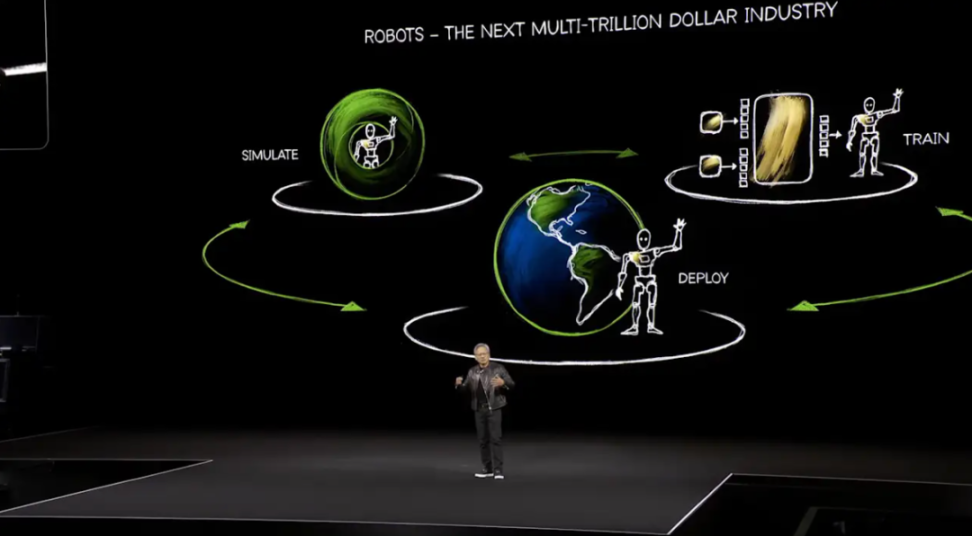

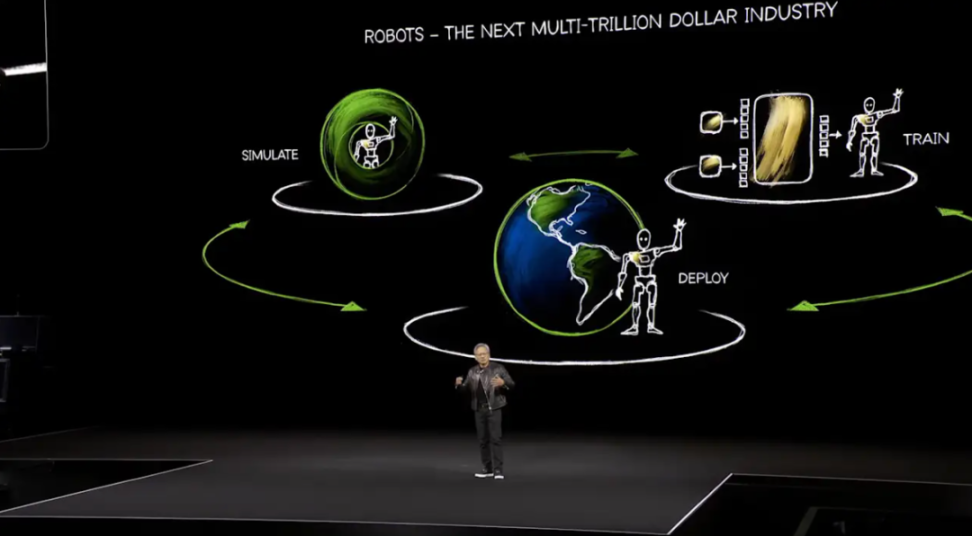

为推进机器人 AI 训练,黄仁勋发布了 Isaac GR00TN1,一款开源基础模型,专为类人机器人开发而设计。这款模型将与升级版 Cosmos AI 结合,生成模拟训练数据,帮助机器人进行更高效的学习。“这真的令人兴奋。提供一个开源平台,意味着更多人可以学习强化学习技术,”宾夕法尼亚大学电子与系统工程教授 Benjamin Lee 评价道,“不仅仅是行业巨头,学术研究者也可以使用这些合成数据进行实验。”黄仁勋还提到,Cosmos 系列 AI 模型可低成本生成高逼真度视频,用于机器人和自动化系统的训练。今年年初的 CES 大会上,他首次介绍了该系列模型。

这一开源模型能够与英伟达 Omniverse 物理仿真工具无缝对接,使得 AI 训练视频更加真实,同时大幅降低传统数据采集成本。相比之下,传统方法如让汽车在现实道路上采集数据,或让人类重复训练机器人,成本极高且耗时漫长。

除了 AI 计算需求,英伟达还宣布与通用汽车(GM)合作,共同开发 AI 定制系统,用于汽车制造、工厂管理和机器人应用。通用汽车的工厂和机器人将借助英伟达 Omniverse 和 Cosmos AI 基础模型进行优化。这些技术可用于创建装配线的“数字孪生”(Digital Twin),通过虚拟测试和生产模拟来减少停机时间。此外,双方还计划训练现有的机器人,使其更高效地完成物料搬运、运输以及精密焊接等任务。在汽车端,通用计划采用英伟达的 Drive AGX 系统,提升高级驾驶辅助系统(ADAS)和安全性能。此前,通用汽车已在 AI 训练中使用英伟达 GPU,而此次合作进一步扩展至汽车工厂的设计和运营领域。英伟达还宣布与谷歌及其母公司 Alphabet 展开合作,以加速 AI 在机器人、医疗、制造和能源领域的应用。双方工程师正携手研发具备抓取能力的机器人、重塑药物研发流程、优化能源网络等。与此同时,英伟达还与 GE HealthCare 合作,利用其最新的 Isaac for Healthcare 医疗设备模拟平台开发自主 X 光技术和超声波应用。该平台集成了预训练模型和基于物理的模拟,可在实际部署前对自主影像系统进行训练和验证,提高准确性和可靠性。此次合作的目标是扩大全球医疗影像技术的可及性。目前,全球约三分之二的人口仍无法获得先进的医学影像服务,而通过引入机器人技术,该合作希望让更多患者受益。英伟达还发布了 Nvidia DGX 系列桌面超级计算机,采用其 Grace Blackwell 平台,提供强大的 AI 计算能力。

- DGX Spark:此前以“Project Digits”亮相,是一款掌上型超级计算机,可提供高达 1000 万亿次运算(TOPS),专为 AI 微调和推理设计。

- DGX Station:一款桌面级超级计算机,具备数据中心级别的计算性能,适用于高强度 AI 计算任务。

英伟达表示,AI 开发者、研究人员、数据科学家和学生都可以使用这些设备,在本地或云端进行模型原型开发、微调和推理。此外,华硕、戴尔、惠普和联想等知名厂商将负责生产这些计算设备。另外,在量子计算领域,英伟达也在加快布局,宣布在波士顿成立英伟达加速量子研究中心(Nvidia Accelerated Quantum Research Center)。该中心将结合量子硬件与 AI 超级计算机,推动量子计算技术的发展,并计划于 2025 年正式投入运营。在演讲的最后,黄仁勋发布了一款开源物理引擎 Newton,专为机器人仿真而设计。这款引擎由英伟达、Google DeepMind 和 Disney Research 共同开发,旨在提升机器人在模拟环境中的训练效果,使其更接近真实世界的物理规律。随后,现场迎来了一位特别的“嘉宾”——小型方形机器人 Blue。它从舞台地板的暗门中跃出,发出电子音回应黄仁勋,并按照指令行动,最终停在他身旁。

原文来源于:

1.https://apnews.com/article/nvidia-gtc-jensen-huang-ai-457e9260aa2a34c1bbcc07c98b7a0555

2.https://www.pymnts.com/artificial-intelligence-2/2025/nvidia-ceo-why-the-next-stage-of-ai-needs-a-lot-more-computing-power/

中文内容由元宇宙之心(MetaverseHub)团队编译,如需转载请联系我们。

最新行业深度研究报告发放中! 资本实验室全新发布 37 页量化报告《 2023 全球区块链应用市场暨产业图谱报告(2023) 》,收录 1000+ 应用案例 ,探索区块链应用趋势 , 入群即可免费领取 。

单卡性能超越 DeepSeek!谷歌最新模型 Gemma 3 突破性能与成本双重壁垒

十大维度碾压 Gemini,一文读懂 DeepSeek 的弯道超车之路